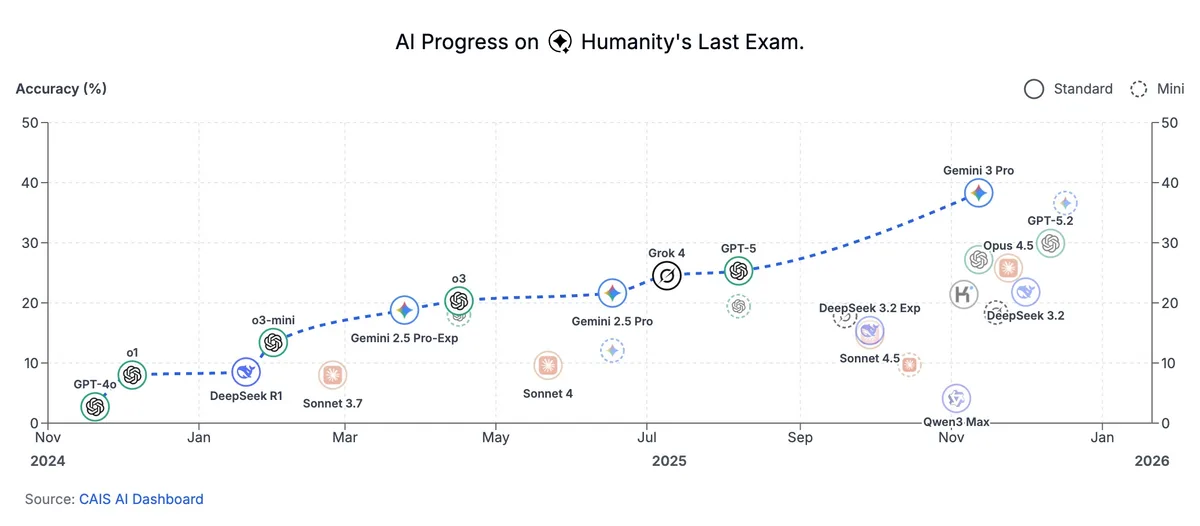

Niciun model de inteligență artificială nu trece de 40% la noul test „Humanity’s Last Exam”, un reper publicat în Nature care încearcă să măsoare performanța pe întrebări aflate la limita cunoașterii umane. Deși clasamentele arată progrese față de primele rezultate din 2025, cercetătorii avertizează că astfel de scoruri sunt ușor de interpretat greșit atunci când sunt folosite ca indicator pentru „inteligența generală” (capacitatea de a rezolva autonom probleme noi, în contexte variate).

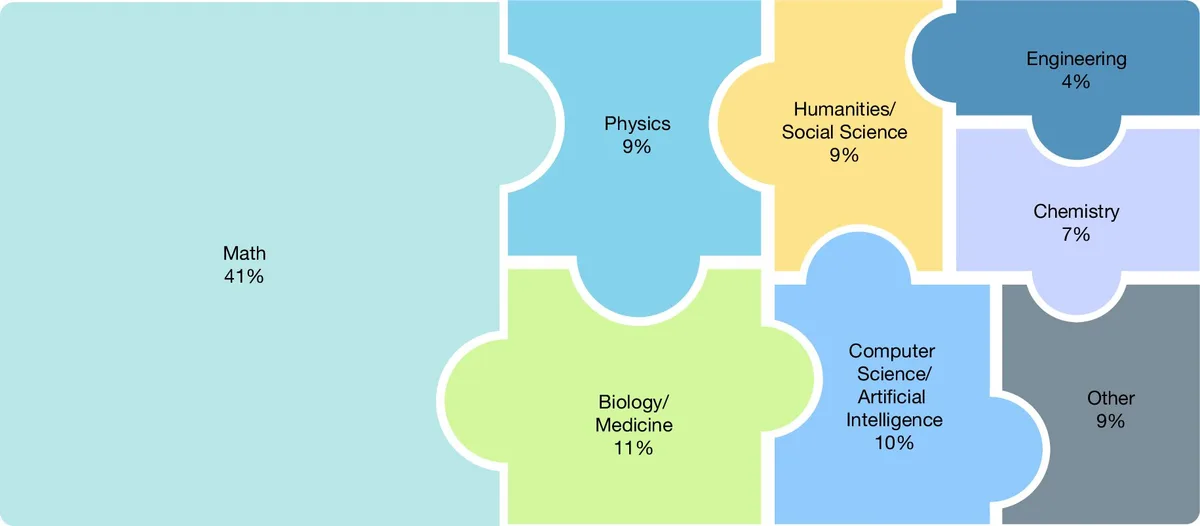

„Humanity’s Last Exam” (HLE) include 2.500 de întrebări de nivel expert din peste 100 de subdomenii academice, de la interpretarea unor inscripții antice până la analiză anatomică, și a fost realizat cu contribuția a aproape 1.000 de profesori și cercetători din peste 500 de instituții din 50 de țări. Conform clasamentului oficial, Google Gemini 3 Pro Preview conduce cu 37,5% acuratețe, urmat de GPT-5 (circa 25%) și Grok 4 (aproximativ 24%), arată Scale AI. În același timp, oamenii-experți ar avea un reper de circa 90%, ceea ce subliniază distanța rămasă până la performanța umană în astfel de sarcini.

Dincolo de cifre, miza pentru industrie și pentru investitori este dacă un astfel de test spune ceva relevant despre „inteligența generală” sau doar despre abilitatea de a răspunde la întrebări închise, verificabile. Creatorii testului recunosc explicit această limitare, notează techxplore:

„Acuratețea ridicată ar demonstra performanță de nivel expert la întrebări închise, verificabile, dar nu ar sugera, de una singură, capacități de cercetare autonomă sau inteligență artificială generală.”

Criticile vizează și faptul că un benchmark (test standardizat) poate împinge companiile să optimizeze modele „pentru clasament”, nu pentru înțelegere generală și transfer de cunoștințe către situații noi. Subbarao Kambhampati, profesor la Arizona State University și fost președinte al Association for the Advancement of Artificial Intelligence, susține că esența inteligenței umane nu este surprinsă de un test static, ci de capacitatea de a evolua și de a aborda întrebări care nici nu existau anterior. O critică înrudită, formulată de analiști, este că „învățarea pentru test” poate ridica scorurile fără să îmbunătățească în mod real competențele generale ale sistemelor, relatează The Conversation.

În acest context, apar și alternative care încearcă să măsoare utilitatea practică, nu doar performanța pe întrebări academice. OpenAI a introdus GDPval, un indicator orientat spre rezultate de muncă (documente de proiect, analize de date și livrabile) în 44 de ocupații din industrii importante pentru PIB-ul SUA, potrivit OpenAI. În paralel, unul dintre contributorii la HLE, Park Ha-eon (CTO la Aim Intelligence), anticipează că vor urma evaluări mai complexe și mai realiste, afirmând că HLE nu va fi „ultimul benchmark”, conform Seoul Economic Daily.

Ce arată, de fapt, aceste rezultate și de ce sunt contestate ca indicator pentru „inteligența generală”:

- Testul măsoară în principal performanța la întrebări închise și verificabile, nu capacitatea de cercetare autonomă sau adaptare la situații noi.

- Un benchmark static poate fi „învățat” prin optimizare țintită, ceea ce îmbunătățește scorul fără garanția unei înțelegeri mai profunde.

- Diferența mare față de reperul uman (circa 90%) sugerează limite semnificative pe sarcini de nivel expert, chiar dacă liderul clasamentului se apropie de 40%.

- Piața începe să caute măsurători mai apropiate de productivitatea reală, prin evaluări bazate pe livrabile profesionale, nu doar pe întrebări academice.